Suche nach sozial kompetentem Roboter

Da stehe ich nun also vor der verschlossenen Tür zu Raum 0.353 im Informatikgebäude, klopfe an... und niemand öffnet. Auf dem Namensschild erspähe ich immerhin auch den Schriftzug „Nasiru Aboki, M.Sc.“. Aber wann ich die Person dahinter heute noch hier antreffen werde, kann mir an diesem Septembermorgen anscheinend niemand verraten. Oder etwa doch?

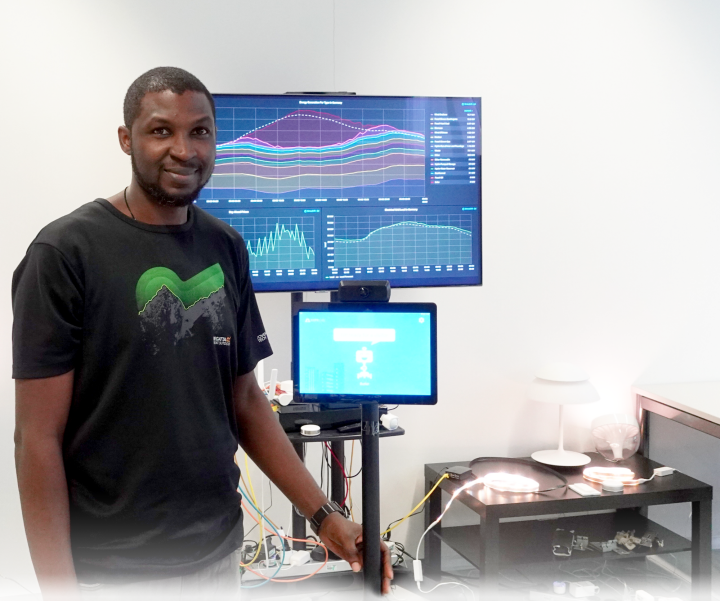

Etwas später finden wir schließlich zueinander und Aboki erzählt mir von einem Roboter mit mancherlei sozialer Kompetenz. Er soll selbstständig Gäste begrüßen oder Kontaktdaten für abwesende Büromitarbeiter aufnehmen. Klingt nach genau dem, was ich an der verschlossenen Pforte zuvor gut hätte brauchen können – ist aber Zukunftsmusik. Denn um so einen Assistenten zu realisieren, braucht es ein umfassendes Framework. Genau daran arbeitet der Doktorand nun schon seit beinahe anderthalb Jahren.

Als Basis dient ihm ein Telepräsenzroboter des Anbieters OhmniLabs: Eine fahrbare Plattform auf drei Rädern, die entfernt an einen Saugroboter erinnert; am schwarzen Fahrgestell ist eine Stange angebracht, an der wiederum Kamera, Bildschirm und Lausprecher montiert sind. Ziemlich komplett für eine ferngesteuerte Kommunikationslösung, aber bei Weitem nicht genug für Abokis Ziele.

Modulare Upgrades für zusätzliche Anwendungen

Weil der Roboter autonom agieren soll, muss er sein Umfeld kennen sowie bewegliche Hindernisse erfassen – schließlich soll das System nicht in die Intimdistanz von Menschen eindringen oder Besucher gar komplett überfahren. Als zusätzlichen Messwertgeber hierfür hat Aboki einen Lasersensor angebracht. Künftig könnte noch eine 3D-Kamera folgen. Darüber hinaus kommuniziert der mobile Roboter per Funk mit weiteren externen Services aus dem Internet sowie fest installierten Sensoren der IoT-Infrastruktur im Labor.

Ähnlich wie die Hardware, kann Aboki auch die Software des Roboters um zusätzliche Fähigkeiten ergänzen. Als Entwicklungsplattform fungiert das Open-Source-basierte Robotic Operating System (ROS); mit darauf aufsetzenden Modulen könnte der maschinelle Assistent künftig auch menschliche Gesichter wiedererkennen oder noch weitaus mehr Aufgaben übernehmen, etwa Botengänge zwischen verschieden Personen.

Studierende schaffen Teillösungen für Mapping, Erkennung und Kommunikation

Welche Nutzungsszenarien sich sinnvoll umsetzen und implementieren lassen, wird nicht nur Aboki in den kommenden Monaten noch weiter ergründen. So steuern die Studenten und Studentinnen des Fachbereichs immer wieder Teillösungen bei und haben bereits Projekte für das Mapping, die Objekterkennung sowie die Kommunikation mit der Laborumgebung abgeschlossen.

Aboki selbst plant, seine von Prof. Dr. Marco Aiello betreute Dissertation über „Autonomous Robotic Systems for Human Support in Offices“ bis Ende 2024 abgeschlossen und verteidigt zu haben.